You may also like

一、说在前面 今天有一个朋友在一个群里提到了N年前经常用的一个软件:UC浏览器,一个子勾起了当年无数的回忆。于是又让我想起来今年过年、在家里无聊时安装的这个最低配的Deepseek版本。晚上在家无的事事,那就把我当初安装时写的笔记稍作整理,放出来跟大家分享一下。 特别说明:这个百无禁忌版本的Deepseek是为了让大家能体验到原汁原味的大模型的输出,不是让你去做坏事的哈,并且这个东西只可自己学习时用,不可对外提供接口,因为这是违反国家政策的。不过另外一句话来讲,事实上有许多东西都是:我可能一辈子都不会去用,但是我不能没有它(卖保险的同学听到这句话,一下子泪目,您说的太对了,明天咱们聊聊?)。 安装要求:1、操作系统:据说Windows Family版本会有一些问题,但是我没试过。不太清楚什么情况。当然,如果是Linux操作系统,那只要你更新到新一点的版本,随便哪个发行版都不会有问题。2、硬盘要求: 版本 内存 CPU 显卡 适用场景 1.5B 8GB+ i5/Ryzen 5 集成显卡或低端独显 基础对话、简单文本生成 7B/8B 16GB+(建议24GB) i7/Ryzen 7 RTX 3060及以上 […]

prompt: 你是一个美食家,熟悉各地的菜品,请根据要求推荐一些菜品,你能够根据别人的需求,推荐许多符合要求的菜品。这些菜品需要满足条件:{Q}。请务必保证自己推荐的内容满足条件。需要满足限定条件中的每个细节。好的,我作为一个美食家,可以为您推荐一些符合您要求的菜品。请告诉我您想要了解哪些地区的菜品,以便我为您推荐符合当地口味的菜品。 Q: 想去安徽黄山玩,那里有什么好吃的A: 安徽黄山是中国著名的旅游胜地,拥有丰富的美食文化。在黄山当地,有很多特色美食值得品尝。以下是一些黄山当地的特色美食: 徽菜:徽菜是安徽黄山地区的特色美食,以清淡、鲜美、营养丰富著称。徽菜的代表菜品有:徽派红烧肉、徽派烤鸭、徽派豆腐、徽派臭干等。 黄山毛豆腐:黄山毛豆腐是黄山地区的传统小吃,以豆腐为主料,配以黄山特产的毛茶,经过发酵制成。黄山毛豆腐口感鲜美,营养丰富,是黄山地区的特色美食之一。 黄山酥鱼:黄山酥鱼是黄山地区的传统名菜,以豆腐、鱼肉为主料,经过煎炸制成。黄山酥鱼口感酥脆,味道鲜美,是黄山地区的特色美食之一。 徽派糕点:徽派糕点是安徽黄山地区的传统小吃,以糕点为主料,经过蒸、烤、煎等方式制成。徽派糕点种类繁多,如:徽派糕点、徽派糖葫芦等。 黄山烧饼:黄山烧饼是黄山地区的传统小吃,以面粉、油、盐、糖等为原料,经过发酵制成。黄山烧饼口感酥脆,味道鲜美,是黄山地区的特色美食之一。 以上是一些黄山当地的特色美食,都是非常值得品尝的。在黄山当地,还可以找到更多的美食,希望您在黄山旅游期间能够品尝到美味的美食。 Q: 推荐一个黄山的特色菜 A: 黄山的特色菜是徽菜,其中最有名的一道菜是徽派红烧肉。徽派红烧肉是一道传统的黄山菜肴,以猪肉为主料,配以黄山特产的茶叶、香料等,经过多道工序制成。这道菜口感鲜美,肉质酥烂,香气扑鼻,是黄山地区的特色美食之一。 徽派红烧肉的制作方法比较复杂,需要经过多次烹饪和调味,但制作出来的菜肴仍然保持着浓郁的香味和口感。如果来到黄山旅游,不妨品尝一下这道美味的徽派红烧肉,感受黄山的美食文化。

一、前言 昨天晚上想给oddtts项目的启动命令行里加一个OddMeta的ASCII art文字的代码输出。 一如既往,想让我自己写那是坚决不可能的,这种事情有大模型了,为什么还要自己来写呢。 但是,(省去一万字),无奈的发现国内外的各个大模型全部翻车了,包括(一定要把它们的大名列出来,恨!!!): 为了这个ASCII码字体,浪费了我一下午,加半个晚上,整个过程只能说用”无语”一词来形容,本来想算了,但是又实在有点气不过,心中默念了 @#¥%……&O()~!无数遍,最后决定还是将整个过程跟大家分享一下。 二、悲伤历程 1. TRAE AI 平时用的比较多的TRAE AI,我就信心满满的打开平时用的TRAE,Come on baby, let’s go. 1)Round 1:信心满满 我让它生成OddMeta,它这给了个啥玩意??? 2)Round 2:要让再次修改 […]

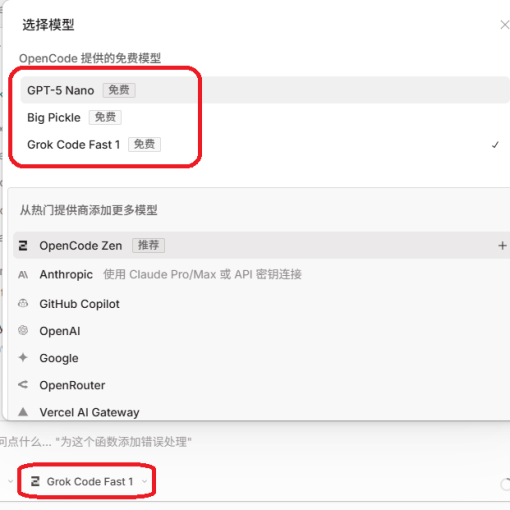

一、前言 上周扣子成为第一个支持skills的国内的大模型,但是这阵子公司这边的事情一直很忙,项目急,领导们都盯着,所以一直没有没时间去测试。 但是事实上之前我已经用open code desktop试过来实现一个skills,只是文章写了一半,一直没发,今天晚上再重新整理了一下,让open code实际来写一个skills,并将完整的过程给大家做一个演示,相信看了之后,任何一个小白(不需要编程知识)都可以来实现自己想要的功能了。 我一直想给小落同学做一个书签功能。原因如下: 当你看到一篇好文章,想保存下来慢慢看,结果网页上广告横幅、导航栏、推荐阅读啥的占了一大半空间。等到真正想看的时候,还得翻半天找正文。更烦人的是,现在很多网站都是单页应用,用JavaScript动态加载内容。直接用浏览器保存或复制粘贴,往往只能拿到个加载动画,完全看不了内容。于是我就想,能不能做一个工具,自动抓取网页,去掉那些乱七八糟的东西,把正文提取出来,保存成干净的Markdown格式?图片也能一并保存下来。 现在刚好用OpenCode Desktop来演示一下,如何实现一个书签功能的Skills,而且可以通过MCP协议接入外部服务。 二、测试运行环境 1. 测试环境 依旧在我这个超过十年的老笔记本上,我的操作系统是Windows 7。如果你是新版本的Windows,或者是Mac OS,或者Linux,整个流程基本上也没什么差别(理论如此哈,我还没验证过,若真在安装使用open code时,有什么问题也可提出来)。 2. 测试使用的版本 Open Code Desktop […]